Den 12 juli 2024 offentliggjordes Förordning (EU) 2024/1689 (”AI-förordningen”) i EU:s officiella tidning. Det innebär att AI-förordningen trädde i kraft den 1 augusti 2024.

AI-förordningen är en omfattande rättsakt, som fastställer harmoniserade regler för utveckling, lansering, ibruktagande och användning av AI-system inom EU. Offentliga och privata aktörer som är involverade i AI-systemens livscykel, såsom leverantörer, användare, distributörer och tillverkare, åläggs flera nya skyldigheter och ansvarsområden.

Många organisationer verkar uppfatta att de inte omfattas av AI-förordningen, då de inte utvecklar eller släpper ut AI-verktyg och/eller AI-tjänster på marknaden. Det är en felaktig föreställning. Ett stort antal organisationer är, eller kommer åtminstone att bli, ansvariga för sin egen AI-användning. Enligt AI-förordningen gäller, något förenklat, att en person eller organisation som använder ett AI-system ska anses vara ”tillhandahållare”, utom när AI-systemet används inom ramen för en personlig icke-yrkesmässig verksamhet. De flesta organisationer, som använder AI, kan således betraktas som ”tillhandahållare” enligt AI-förordningen. I denna egenskap kan de omfattas av flera regulatoriska krav.

De olika skyldigheterna enligt AI-förordningen börjar att gälla vid olika tidpunkter, beroende på vilken art eller omfattning AI-systemet eller AI-användningen har. De flesta av skyldigheterna börjar att gälla två år efter AI-förordningens ikraftträdande (augusti 2026). Det gäller bl.a. många av de skyldigheter som omfattar AI-system med hög risk. Beträffande AI-system med hög risk som omfattas av viss produktsäkerhetslagstiftning kommer skyldigheterna dock att börja gälla först efter 36 månader (augusti 2027). Reglerna om styrningsstruktur och bestämmelserna om AI-modeller för allmänna ändamål kommer att börja gälla efter 12 månader (augusti 2025). De allmänna reglerna, och de bestämmelser som helt förbjuder vissa typer av AI-användningsområden, kommer att börja gälla sex månader efter AI-förordningens ikraftträdande (februari 2025). Härutöver anger AI-förordningen ett antal specifika tidsundantag, för vissa system som har introducerats på marknaden eller tagits i bruk innan förordningen träder i kraft. Exempelvis har leverantörer av AI-modeller för allmänna ändamål, som har släppts ut på marknaden minst 12 månader före AI-förordningens ikraftträdande, 36 månader på sig att uppfylla kraven (augusti 2017).

Organisationer som inte uppfyller AI-förordningens krav riskerar att drabbas av allvarliga rättsliga, anseendemässiga och ekonomiska påföljder. Det mest effektiva sättet att säkerställa efterlevnad av AI-förordningen är att vidta förebyggande åtgärder i ett tidigt skede. Nedan anges åtta centrala åtgärder, som kan minska de regulatoriska riskerna.

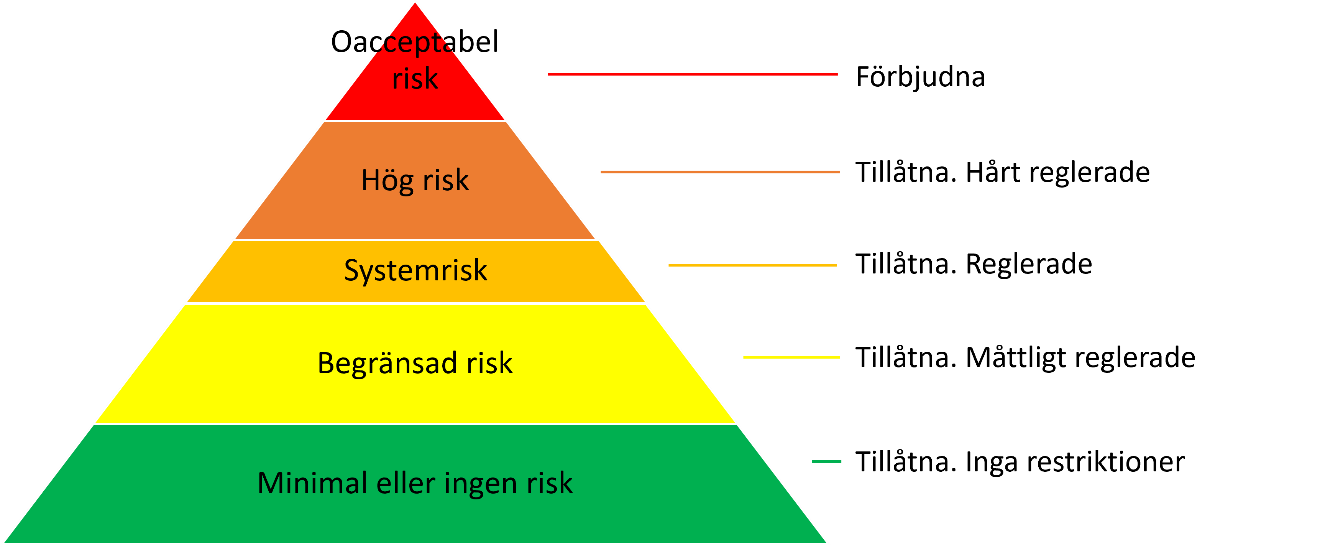

Den slutliga versionen av AI-förordningen bygger, i huvudsak, på en indelning av AI-system i fem risknivåer: oacceptabel risk, hög risk, systemrisk, begränsad risk och minimal/ingen risk. AI-modeller för allmänna ändamål som inte medför någon systemrisk kan, argumentationsvis, sägas tillhöra kategorin ”begränsad risk”.

Vissa AI-system är undantagna från AI-förordningen, exempelvis system som används uteslutande för militär verksamhet, forskning eller personlig icke-yrkesmässig verksamhet.

AI-användningsområden som anses medföra oacceptabla risker, såsom användning av system för känsloigenkänning på arbetsplatser och i utbildningsmiljöer samt missbruk av AI-teknik för social poängsättning, är förbjudna. Förbjuden användning är oförenlig med EU:s värderingar och torde inte förekomma i någon betydande omfattning i Europa. Det är dock sannolikt att många organisationer tillhandahåller eller använder AI-funktioner på ett eller flera sätt som innebär hög risk enligt AI-förordningens bestämmelser. Organisationer som tillhandahåller eller använder AI-system med hög risk måste uppfylla flera hårda krav.

Ett viktigt första steg för många organisationer är således att identifiera och detaljerat förteckna sina AI-funktioner, för en efterföljande riskbedömning. Det är inte ovanligt att organisationer använder flera AI-baserade lösningar. Vissa AI-lösningar är specialbyggda. Andra AI-funktioner är integrerade med olika plattformar som används dagligen (såsom AI-understödda standardapplikationer och SaaS-lösningar) och kan därför vara svårare att upptäcka. Vissa organisationer använder hundratals AI-lösningar i sin verksamhet. Genom att inventera AI-baserade produkter, tjänster och funktioner kan AI-systemen analyseras och klassificeras utifrån de risknivåer som definieras i AI-förordningen.

En sådan inventering kräver, bland annat, tillräcklig kunskap om vilka system som anses vara ”AI-system” enligt AI-förordningen. AI-förordningens definition av ”AI-system” baseras på vissa centrala egenskaper, som skiljer AI-system från enklare och traditionella mjukvarusystem eller programmeringsmetoder. AI-förordningen omfattar inte system som bygger på regler som definieras enbart av fysiska personer för att automatiskt utföra operationer. Ett ”AI-system” definieras således som ”ett maskinbaserat system som är utformat för att fungera med varierande grad av autonomi och som kan uppvisa anpassningsförmåga efter införande och som, för uttryckliga eller underförstådda mål, drar slutsatser härledda från den indata det tar emot, om hur utdata såsom förutsägelser, innehåll, rekommendationer eller beslut som kan påverka fysiska eller virtuella miljöer ska genereras”. De mest centrala begreppen är ”autonomi” och ”drar slutsatser”.

Vidare bör noteras att de risknivåer, som regleras i AI-förordningen, inte alltid är ömsesidigt uteslutande. Exempelvis kan ett AI-system, som utgör en systemrisk, också betraktas som ett AI-system med hög risk, beroende på i vilket syfte systemet används.

Innan en organisation fördjupar sig i AI-förordningens detaljerade krav, fattar beslut om diverse förändringar av policys och rutiner, justerar sina avtal m.m., bör organisationen söka fastställa vilka, om några, av organisationens AI-system som utgör hög risk enligt AI-förord¬ningen. AI-förordningen använder tre huvudkriterier för att avgöra om ett AI-system ska klassificeras som ett AI-system med hög risk:

Ett AI-system som sådant kan ibland betraktas som en produkt. Om en sådan produkt redan regleras av särskild EU-lagstiftning (som definieras i bilaga I till AI-förordningen) anses produkten vara ett AI-system med hög risk om den kräver en tredjepartsbedömning av överensstämmelse innan den släpps ut på marknaden eller används i EU. Exempel på sådana produkter är medicintekniska produkter, industrimaskiner, leksaker, flygplan och bilar.

AI-system som används som säkerhetskomponenter i vissa produkter klassificeras också som AI-system med hög risk, om produkterna regleras av viss EU-lagstiftning (som definieras i bilaga I till AI-förordningen) som kräver tredjepartsbedömning av överensstämmelse före marknadsintroduktion eller användning i EU. Detta gäller AI-system i produkter såsom medicintekniska produkter, industrimaskiner, järnvägsinfrastruktur, hissar och anordningar för förbränning av gasformiga bränslen.

AI-system ska också anses utgöra AI-system med hög risk om de omfattas av bilaga III till AI-förordningen. Dessa system anses kunna orsaka stor skada och används inom områden såsom biometri, kritisk infrastruktur, utbildning, personalrekrytering, tillgång till väsentliga tjänster, brottsbekämpning, immigration samt rättskipning och demokratiska processer.

Ett AI-system ska inte betraktas som ett AI-system med hög risk om det inte utgör en betydande risk för skada på fysiska personers hälsa, säkerhet eller grundläggande rättigheter, förutsatt att systemet uppfyller särskilda kriterier. Några exempel på sådana kriterier är att AI-systemet är avsett att utföra en snäv processuell uppgift eller att förbättra resultatet av tidigare slutförd mänsklig verksamhet. AI-system som används för profilering av fysiska personer klassificeras dock automatiskt som AI-system med hög risk.

När en organisation har riskbedömt sina AI-system måste organisationen avgöra om den uppfyller AI-förordningens krav. En noggrann genomgång av AI-förordningen är nödvändig för att kunna kontrollera organisationens efterlevnad. Bedömningen kräver, bland annat, att organisationen fastställer sin roll (eller sina roller) i AI-värdekedjan. Organisationen kan t.ex. vara leverantör, tillhandahållare, distributör, tillverkare och/eller importör. För AI-system med hög risk innehåller AI-förordningen regler om t.ex. riskhanteringssystem, datakvalitet, transparens, mänsklig kontroll, riktighet, registrering, kvalitetsstyrning, övervakning, loggning och incidentrapportering.

En GAP-analys syftar till att klargöra organisationens nuvarande situation, i jämförelse med den situation som eftersträvas eller måste uppnås. En sådan analys kan hjälpa organisationen att uppfylla AI-förordningens krav. Genom att identifiera och prioritera de områden som måste förbättras och förändras kan organisationen fokusera på centrala efterlevnadsfrågor. En noggrann GAP-analys underlättar således för organisationen att bedöma i vilken utsträckning dess verksamhet är förenlig med reglerna i AI-förordningen.

GAP-analysen bör resultera i utformning av en individualiserad strategi för hantering av identifierade brister. En sådan strategi bör fastslå tidsramar, ansvarsområden och nödvändiga resurser. Specifika åtgärder och milstolpar bör definieras för varje område. Målet är en detaljerad handlingsplan som beskriver de steg som krävs. AI-specifika förfaranden för efterlevnad, genom AI-systemets hela livscykel, bör beskrivas och integreras med befintliga IT-processer. Genom att i möjligaste mån förena nya åtgärder med befintliga strukturer och processer kan organisationen minska antalet störningar och underlätta en smidig övergång till rutiner som uppfyller AI-förordningens krav.

Samarbete mellan organisationens olika avdelningar, och en tydlig ansvarsfördelning som klargör både tekniska och juridiska roller, kan vara avgörande för att kunna genomföra de förändringar som krävs. Ett första lämpligt steg kan vara att uppdatera organisationens befintliga IT-policy, så att den överensstämmer med kraven i AI-förordningen. Sådant arbete omfattar att utveckla en relevant uppförandekod, som bör fastslå etiska principer och riktlinjer för utveckling och/eller användning av AI. För AI-system med hög risk kan riktlinjerna omfatta riskhantering, datakvalitet, transparens, mänsklig kontroll, riktighet, registrering, kvalitetsstyrning, övervakning, loggning och incidentrapportering. Organisationen bör också säkerställa att relevant personal har tillräcklig utbildning och behörighet att ingripa i AI-relaterad verksamhet vid behov. Detta är endast några exempel på åtgärder som en GAP-analys kan föranleda.

När det är möjligt och ekonomiskt rationellt kan vissa krav, som formellt gäller endast AI-system med hög risk, frivilligt tillämpas på AI-system med lägre risk. En sådan ordning syftar inte endast till att främja etisk och pålitlig AI-användning i största allmänhet. Mer omsorgsfulla rutiner kan också minska de regulatoriska risker som kan uppstå vid felaktig (läs: alltför tillåtande) klassificering av ett AI-systems risknivå. Det kan vara svårt eller mycket svårt för en organisation att göra en korrekt riskbedömning av ett AI-system, exempelvis beträffande systemets inverkan på grundläggande rättigheter. Att behandla ett system som ett AI-system med hög risk, när en sådan klassificering inte är formellt nödvändig, kan dock medföra onödiga kostnader och oönskad komplexitet och kan även minska organisationens (och/eller dess samarbetspartners) incitament att utveckla, anpassa, finansiera och/eller använda systemet.

Berörda aktörer bör eftersträva att skapa en kultur, som uppmuntrar regelefterlevnad och etisk användning av AI. För många organisationer är det viktigt att utbilda och träna de anställda som använder eller påverkas av AI-system, för att säkerställa att personalen har nödvändiga färdigheter och kunskaper. Berörd personal bör känna till AI-förordningens krav och måste förstå sin roll i organisationens arbete med efterlevnaden.

Om en organisation ingår (eller redan har ingått) avtal om utveckling, köp och/eller användning av AI-system eller AI-funktioner, bör organisationen säkerställa att parternas roller och ansvarsområden är tillräckligt specificerade och reglerade, för att säkerställa efterlevnad av AI-förordningen. Sådana avtal bör innehålla villkor om ansvar och bör även reglera parts möjligheter att vidta åtgärder vid incidenter eller bristande efterlevnad.

Som ett minimum bör varje berörd organisation kommunicera och samråda med partners som tillhandahåller eller använder AI-system eller AI-komponenter, för att säkerställa att sådana partners är medvetna om och följer organisationens AI-policy och kraven i AI-förordningen. Sådan samverkan bör vara ägnad att underlätta utbyte av information och feedback beträffande AI-systemens prestanda, risker och effekter, och bör tillåta identifiering och hantering av eventuella problem.

Oavbruten regelefterlevnad kräver att berörda aktörer håller sig uppdaterade om eventuella uppdateringar och/eller justeringar av AI-förordningen och anknytande lagstiftning (såsom det föreslagna direktivet om skadeståndsansvar gällande AI). En organisation bör ha förmåga att modifiera sina policys och rutiner i takt med att nya regler och/eller vägledning tillgängliggörs. Deltagande i branschforum, intresseorganisationer, utbildningar och relevanta diskussioner om AI-reglering och AI-rutiner kan underlätta för organisationen att hålla sig uppdaterad om den senaste utvecklingen.

AI-förordningen tar drygt 140 sidor text i anspråk, inklusive ingress och bilagor, och är således en mycket omfattande rättsakt (mer omfattande än GDPR). Förordningen innehåller ett stort antal bestämmelser och krav, inklusive flera centrala definitioner och korshänvisningar. Olika kapitel och regler blir tillämpliga vid olika tidpunkter. En och samma organisation kan behöva iaktta flera successiva deadlines. AI-förordningens bestämmelser är dessutom föremål för EU-kommissionens löpande utvärdering och översyn, vilket innebär att reglerna kommer att ändras och/eller kompletteras över tid. Organisationer som inte efterlever AI-förordningens krav riskerar att drabbas av höga sanktionsavgifter och andra allvarliga konsekvenser. Således måste berörda aktörer uppmärksamma och hålla jämna steg med rättsutvecklingen. Mot denna bakgrund kan det vara lämpligt att anlita juridisk och regulatorisk expertis, för att minska risken att bryta mot AI-förordningens bestämmelser.

Genom att vidta ovanstående åtgärder kan en organisation inte endast minska risken att bryta mot AI-förordningens regler, utan kan också bidra till ansvarsfull och etisk utveckling och användning av AI. Sådan proaktivitet leder till ökat förtroende på marknaden och kan generellt sägas utgöra en grundläggande förutsättning för hållbar, lagenlig och framgångsrik AI-användning i Europa.